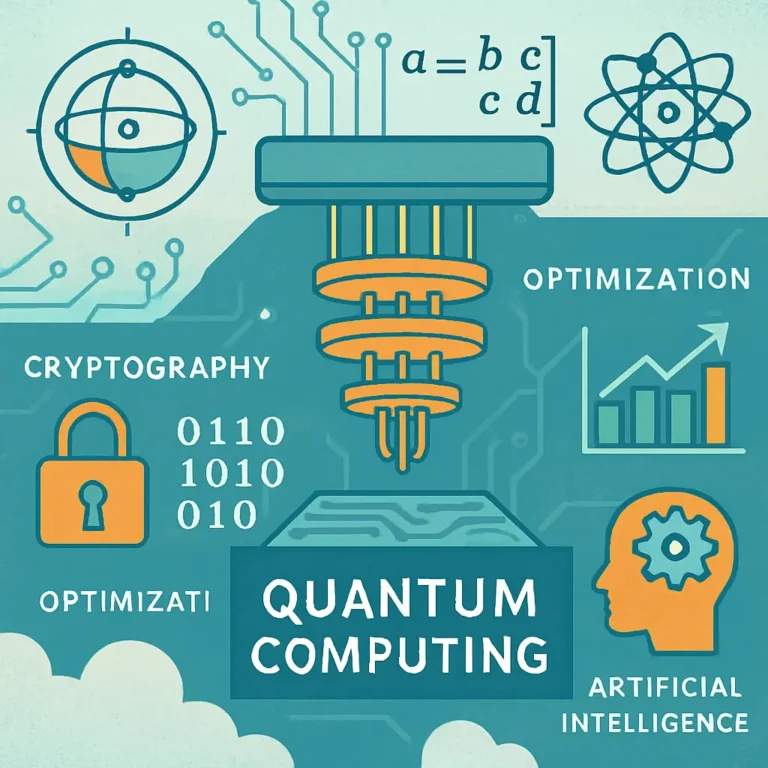

Top Breakthroughs in Quantum Computing 2025

Introduction Quantum computing is on the brink of a revolution. By 2025, it promises to transform industries and redefine technology. This article explores the top breakthroughs expected in quantum computing by 2025. Major tech companies are investing heavily in quantum research. Google, IBM, and Microsoft are leading the charge. Quantum supremacy is a key milestone anticipated soon. It marks the point where quantum computers outperform classical ones. Quantum error correction is another critical area of research. It aims to make quantum computers more reliable and practical. The development of quantum algorithms is essential. These algorithms will solve complex problems beyond the reach of classical computers. Quantum cryptography is set to enhance data security. It promises to make data virtually unbreakable. Stay tuned as we delve into these exciting advancements in quantum tech 2025. The Quantum Computing Landscape in 2025 The landscape of quantum computing in 2025 is nothing short of dynamic. Rapid advancements characterize this space. Quantum computing is moving beyond theory and into real-world applications. Various industries are gearing up for a quantum leap. Several key players are reshaping the industry. These include both established tech giants and innovative startups. They are pivotal in driving this change. The following elements define the 2025 quantum landscape: Wide adoption across diverse industries Increased collaboration between academia and industry Significant government investments in quantum research Globally, investments in quantum tech are skyrocketing. Countries are vying for leadership in this pivotal field. This competition is fueling unprecedented innovation and development. Quantum computing is no longer a distant dream. It’s an evolving reality, set to revolutionize how we live and work. The expectations for what it can achieve by 2025 are vast and visionary. Major Quantum Computing Breakthroughs of 2025 …